Tabla de contenidos

geekzillos, les tenemos novedades en el mundo de la Inteligencia Artificial, esta vez de la mano de Gemma, una nueva generación de modelos abierto de Google. ¿Están listos para conocer los detalles?

Modelos abiertos Gemma.

Gemma es una familia de modelos abiertos livianos y de última generación construidos a partir de la misma investigación y tecnología utilizada para crear los modelos Gemini. Desarrollada por Google DeepMind y otros equipos de Google, Gemma está inspirada en Géminis y el nombre refleja el latín gemma , que significa “piedra preciosa”. Además de los pesos de nuestros modelos, también estamos lanzando herramientas para respaldar la innovación de los desarrolladores, fomentar la colaboración y guiar el uso responsable de los modelos Gemma.

Gemma está disponible en todo el mundo a partir de hoy. Estos son los detalles clave que debe conocer:

- Pesas modelo en dos tamaños: Gemma 2B y Gemma 7B. Cada tamaño se lanza con variantes previamente entrenadas y ajustadas por instrucciones.

- Un nuevo kit de herramientas de IA generativa responsable proporciona orientación y herramientas esenciales para crear aplicaciones de IA más seguras con Gemma.

- cadenas de herramientas para inferencia y ajuste fino supervisado (SFT) en todos los marcos principales: JAX, PyTorch y TensorFlow a través de Keras 3.0 nativo .

- Los portátiles Colab y Kaggle listos para usar, junto con la integración con herramientas populares como Hugging Face , MaxText , NVIDIA NeMo y TensorRT-LLM , facilitan el inicio de Gemma.

- Los modelos Gemma previamente entrenados y ajustados por instrucciones se pueden ejecutar en su computadora portátil, estación de trabajo o Google Cloud con una fácil implementación en Vertex AI. Además, Google Kubernetes Engine (GKE).

- La optimización en múltiples plataformas de hardware de IA garantiza un rendimiento líder en la industria, incluidas las GPU NVIDIA y las TPU de Google Cloud .

- Los términos de uso permiten el uso comercial y la distribución responsable para todas las organizaciones, independientemente de su tamaño.

Rendimiento de última generación en tamaño

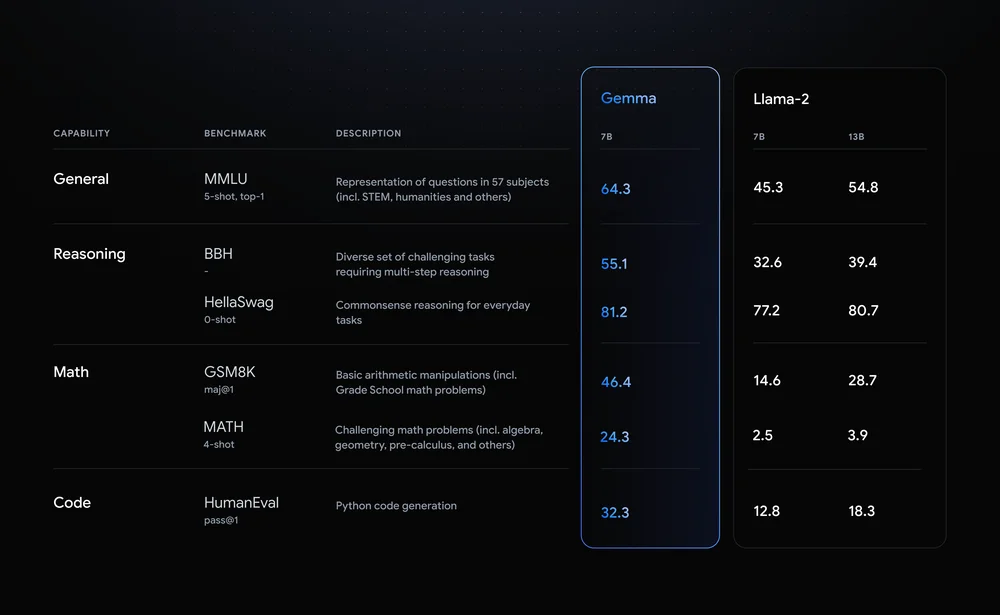

Los modelos Gemma comparten componentes técnicos y de infraestructura con Gemini , nuestro modelo de IA más grande y más capaz ampliamente disponible en la actualidad. Esto permite a Gemma 2B y 7B lograr el mejor rendimiento de su clase para sus tamaños en comparación con otros modelos abiertos. Y los modelos Gemma son capaces de ejecutarse directamente en una computadora portátil o de escritorio para desarrolladores. En particular, Gemma supera modelos significativamente más grandes en puntos de referencia clave. Y al mismo tiempo cumple con nuestros rigurosos estándares para resultados seguros y responsables. Consulte el informe técnico para obtener detalles sobre el rendimiento, la composición del conjunto de datos y las metodologías de modelado.

Responsable por diseño

Gemma está diseñada teniendo en cuenta nuestros principios de IA . Como parte del objetivo de hacer que los modelos previamente entrenados de Gemma sean seguros y confiables, utilizamos técnicas automatizadas para filtrar cierta información personal y otros datos confidenciales de los conjuntos de entrenamiento. Además, utilizamos un amplio aprendizaje de refuerzo y ajuste a partir de la retroalimentación humana (RLHF) para alinear nuestros modelos ajustados a la instrucción con comportamientos responsables. Para comprender y reducir el perfil de riesgo de los modelos Gemma. Google realizó evaluaciones sólidas que incluyeron formación de equipos rojos manuales, pruebas adversas automatizadas y evaluaciones de las capacidades del modelo para actividades peligrosas. Estas evaluaciones se describen en la Tarjeta Modelo .

También llegará un nuevo kit de herramientas de IA generativa responsable junto con Gemma. Para ayudar a los desarrolladores e investigadores a priorizar la creación de aplicaciones de IA seguras y responsables. El kit de herramientas incluye:

- Clasificación de seguridad: proporcionamos una metodología novedosa para construir clasificadores de seguridad sólidos con ejemplos mínimos.

- Depuración: una herramienta de depuración de modelos le ayuda a investigar el comportamiento de Gemma y abordar posibles problemas.

- Orientación: puede acceder a las mejores prácticas para creadores de modelos basadas en la experiencia de Google en el desarrollo e implementación de modelos de lenguaje grandes.

Optimizado en marcos, herramientas y hardware

Puede ajustar los modelos de Gemma con sus propios datos para adaptarlos a las necesidades específicas de la aplicación, como el resumen o la generación aumentada de recuperación (RAG). Gemma admite una amplia variedad de herramientas y sistemas:

- Herramientas de múltiples marcos: traiga su marco favorito, con implementaciones de referencia para inferencia y ajuste en Keras 3.0 de múltiples marcos, PyTorch nativo, JAX y Hugging Face Transformers.

- Compatibilidad entre dispositivos: los modelos Gemma se ejecutan en tipos de dispositivos populares, incluidos portátiles, ordenadores de sobremesa, IoT, dispositivos móviles y la nube, lo que permite capacidades de IA ampliamente accesibles.

- Plataformas de hardware de vanguardia: nos hemos asociado con NVIDIA para optimizar Gemma para las GPU de NVIDIA , desde el centro de datos hasta la nube y las PC locales RTX AI, lo que garantiza un rendimiento líder en la industria y la integración con tecnología de vanguardia.

- Optimizado para Google Cloud: Vertex AI proporciona un amplio conjunto de herramientas MLOps con una variedad de opciones de ajuste e implementación con un solo clic mediante optimizaciones de inferencia integradas. La personalización avanzada está disponible con herramientas Vertex AI totalmente administradas o con GKE autoadministrado, incluida la implementación en una infraestructura rentable en GPU, TPU y CPU desde cualquier plataforma.

Créditos gratuitos para investigación y desarrollo.

Gemma está diseñada para la comunidad abierta de desarrolladores e investigadores que impulsan la innovación en IA. Puede comenzar a trabajar con Gemma hoy usando acceso gratuito en Kaggle. Un nivel gratuito para portátiles Colab y $300 en créditos para usuarios nuevos de Google Cloud. Los investigadores también pueden solicitar créditos de Google Cloud de hasta 500.000 dólares para acelerar sus proyectos.

Por último, los invitamos a escuchar nuestros podcasts: Top Tech y Top Gaming disponibles en Spotify.