Google trabaja duro para mejorar las búsquedas, ante el hecho de que de los miles de millones de búsquedas que se hacen todos los días, el 15% de las consultas nunca se habían hecho antes. Una muestra es BERT, una técnica neuronal.

La comprensión del lenguaje

El Buscador se enfoca en comprender el lenguaje. Descubre lo que está buscando un usuario y muestra información útil en la web, sin importar cómo el usuario deletree o combine las palabras en una consulta. Pero todavía falta mejorar, especialmente cuando se trata de consultas complejas o cuando se usa un lenguaje coloquial.

De hecho, esa es una de las razones por las cuales las personas a menudo usan algún tipo de “palabra clave” para escribir cadenas de palabras que creen que serán comprensibles, pero que en realidad no se parece a la forma en la que plantearían la pregunta normalmente.

Con los últimos avances en investigación en la ciencia de la comprensión del lenguaje (gracias al Aprendizaje Automático), Google hace una mejora significativa en la forma en que entiende las consultas, lo que representa el mayor avance de los últimos cinco años, y uno de los más importantes en la historia del Buscador de Google.

Aplicación de modelos BERT al Buscador

El año pasado, Google presentó y liberó el código de una técnica neuronal basada en redes para el entrenamiento previo de procesamiento de lenguaje natural (PNL) llamada “Bidirectional Encoder Representations from Transformers” o para abreviarlo: BERT. Esta tecnología permite a cualquiera entrenar su propio sistema de respuesta a preguntas de última generación.

Este avance es consecuencia de la investigación de Google sobre transformadores: modelos que procesan palabras en relación con todas las otras palabras en una oración, en lugar de una por una en orden. Por lo tanto, los modelos BERT pueden considerar el contexto completo de una palabra al observar las palabras que vienen antes y después, algo particularmente útil para comprender la intención detrás de las consultas de búsqueda.

Asimismo, Google utilizó por primera vez los TPUs en la nube más recientes para ofrecer resultados de búsqueda y acercar al usuario información más relevante rápidamente.

Descifrando consultas

Cuando se trata de clasificar los resultados, BERT ayudará al Buscador a comprender mejor una de cada 10 búsquedas en inglés en Estados Unidos y con el tiempo llevaremos esto a más idiomas y localidades.

Para consultas más largas y cotidianas, o búsquedas en las que las preposiciones “para” y “por” son muy importantes para el significado, el Buscador podrá comprender el contexto de las palabras en la consulta.

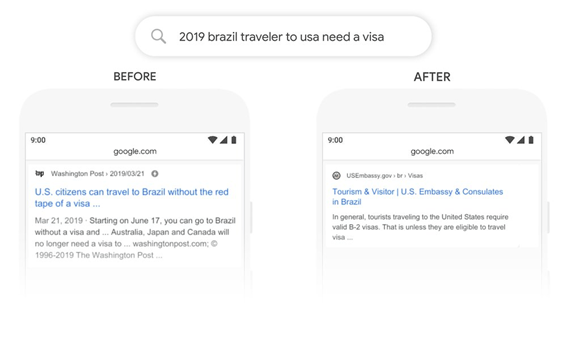

Por ejemplo, aquí hay una búsqueda: “2019 viajero brasileño a estados unidos necesita una visa”. La palabra “a” y su relación con las otras palabras en la consulta son particularmente importantes para comprender el significado. Se trata de un brasileño que viaja a los Estados Unidos, y no al revés.

Anteriormente, los algoritmos de Google no entendían la importancia de esta conexión, y mostraba resultados sobre ciudadanos estadounidenses que viajan a Brasil. Con BERT, el Buscador puede comprender esta distinción y saber que la palabra común “a” realmente importa mucho aquí, con lo que se puede proporcionar un resultado mucho más relevante para esta consulta.

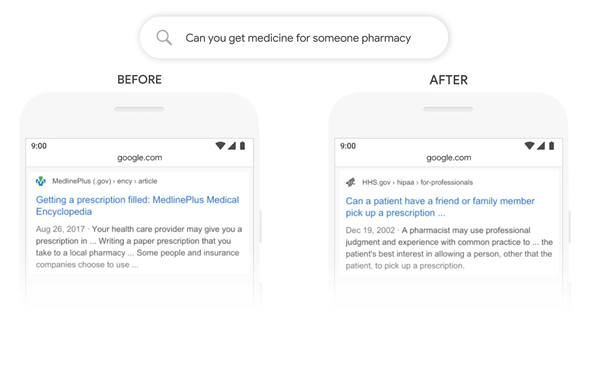

Con el modelo BERT, podemos entender mejor que “para alguien” es una parte importante de la consulta “puedes conseguir una medicina para alguien en la farmacia”, pero antes no se podía identificar el significado y se mostraban resultados generales sobre cómo surtir recetas médicas.

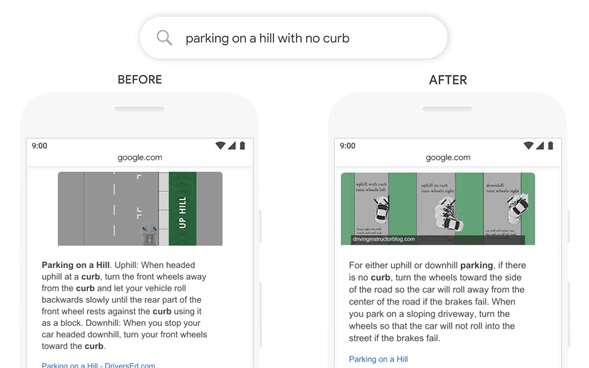

En el pasado, una consulta como “estacionarse en una colina sin acera” confundiría a los sistemas de Google: porque daban demasiada importancia a la palabra “acera” e ignoraban la palabra “sin”, sin entender cuán crítica era esa palabra para responder adecuadamente a esta consulta. ¡Entonces mostraba resultados para estacionarse en una colina con acera!

La búsqueda no es un problema resuelto

BERT mejora el Buscador para más personas en todo el mundo. Una característica importante es que puede aprender de un idioma y aplicarlos a otros. Por lo tanto, puede tomar modelos que aprenden de las mejoras en inglés (idioma utilizado en la gran mayoría del contenido web) y aplicarlas a otros idiomas. Esto ayuda a arrojar mejores resultados en los muchos idiomas en los que se ofrece el Buscador de Google.

En el caso de los fragmentos destacados, Google utiliza un modelo BERT para mejorarlos en las dos docenas de países en donde está disponible esta función, y observa mejoras significativas en idiomas como coreano, hindi y portugués.

Google espera que los usuarios puedan dejar a un lado el lenguaje con palabras clave y realizar búsquedas de una manera que resulte natural.