Esto se empieza animar. La fiesta de la inteligencia artificial generativa tiene un nuevo invitado, y ¡vaya invitado! Me refiero a Nvidia, que acaba de hacer público su propio modelo de inteligencia artificial generativa que lleva por nombre ‘Chat with RTX’. Un movimiento hasta cierto punto obvio al conocer el poder de procesamiento que tienen sus GPUs y desarrollo de chips.

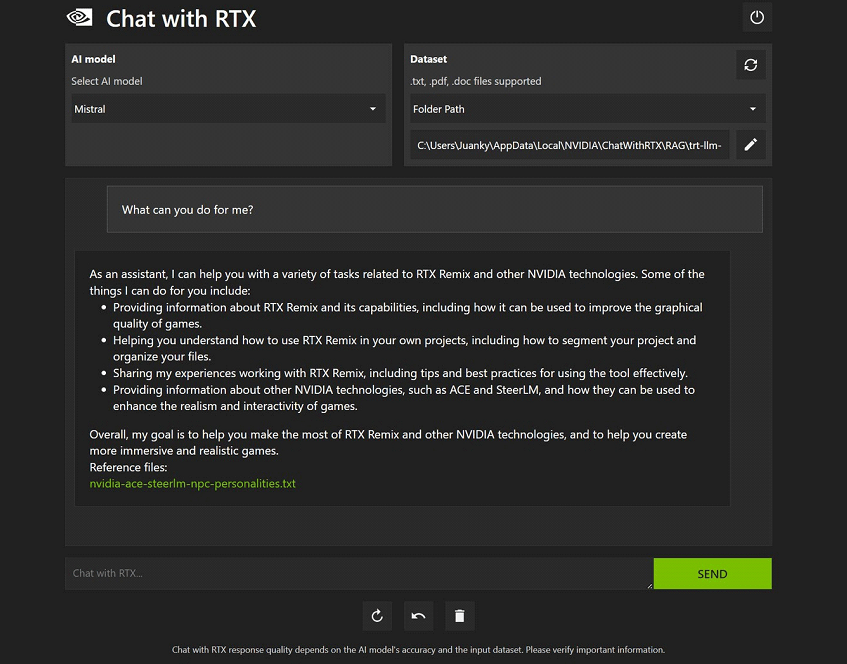

A diferencia de otros modelos de IA, como ChatGPT o Copilot, la solución de Nvidia se ejecuta en local en nuestra PC y se alimenta exclusivamente de nuestro contenido, previa autorización nuestra. Es decir, la información no sale de la computadora, no se envía a ningún otro servidor, y sólo usaremos información que nosotros queramos usar.

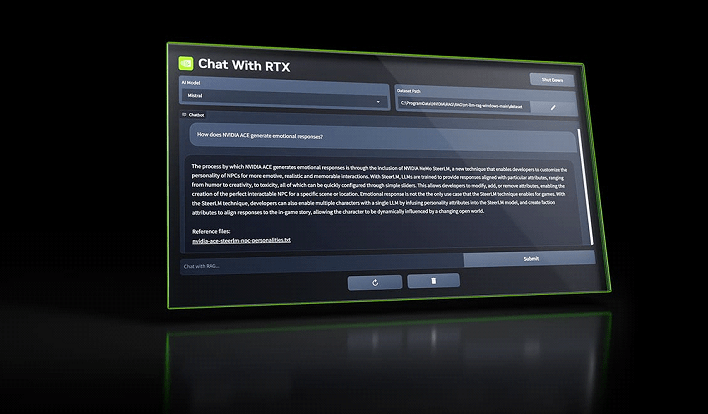

Eso sí, necesitaremos tener una PC con una GPU RTX serie 30 o 40 y al menos 8 GB de VRAM. Si contamos con esto podremos descargar la aplicación de Chat with RTX desde el sitio de Nvidia y listo. Pero ojo, estamos ante una versión preliminar que se siente hasta cierto punto como un demo. La interfaz es simple y poco pulida, y será normal tener algunos errores. Pero lo interesante es lo que puede hacer ahora mismo, que es una pequeña mirada a sus capacidades futuras.

Como ya mencionaba, Chat with RTX se alimenta del contenido en nuestra PC, previa autorización nuestra. Es decir, podemos darle acceso a archivos de Word, Excel, Power Point y PDFs, incluso acceso a carpetas completas con nuestros archivos. Pero lo más interesante es que podemos darle URLs de listas de videos de YouTube y será capaz de indexar todo el contenido.

¿Y para que nos sirve todo esto? Imaginemos que estamos buscando información de algún dato para una tarea, pero no tenemos tiempo de ver 30 videos (o más) de podcast especializados. Entonces hacemos una lista de videos en YouTube, metemos la URL en Chat with RTX y listo, ahora podemos pedirle un resumen del dato que nos interese dentro de esos 30 videos.

Lo mismo con los documentos que tenemos en nuestra PC. Por ejemplo, estamos buscando datos de ventas de ciertos productos durante los últimos 10 años, y tenemos los archivos en Excel. Revisar uno por uno sería una tarea pesada y tediosa, pero ahora con Chat with RTX esto se resume a unos cuantos minutos.

En resumen, Chat with RTX se nos presenta como una herramienta primordial (y toda una bendición) para aquellos que hacemos investigación de datos o para quienes necesiten analizar una gran cantidad de documentos. Los resultados van desde un simple resumen, hasta menciones especificas y análisis con todo y conclusiones.

Chat with RTX se instala en nuestra PC como una plataforma Python y ocupa alrededor de 3GB de RAM. Se basa en modelos Mistral y Llama 2, que sirven para consultar y analizar el contenido de nuestra PC. Y aprovecha todo el poder de procesamiento de los núcleos Tensor de las GPU RTX de Nvidia, esto para acelerar el proceso de búsqueda.

Con la llegada de Chat with RTX de Nvidia ahora tenemos un nuevo jugador en el campo de IA generativa, una que poco a poco se va nutriendo de importantes plataformas como el caso de ChatGPT de OpenAI, Copilot de Microsoft y la recién renombrada Gemini de Google. Y ojo, que Apple ya promete que este mismo 2024 también se suma a esta fiesta.