NVIDIA ha lanzado DGX SuperPOD, y con esto se amplía a decenas de miles de superchips Grace Blackwell mediante el uso de las redes NVIDIA más avanzadas, el software NVIDIA Full-Stack AI y las funciones de almacenamiento hasta 576 GPU Blackwell conectadas como una sola con NVIDIA NVLink. Los expertos en sistemas NVIDIA aceleran la implantación de una infraestructura de IA inmediata.

NVIDIA acaba de anunciar su superordenador de IA de última generación, el NVIDIA DGX SuperPOD™ basado en los superchips NVIDIA GB200 Grace Blackwell, que permite procesar modelos de billones de parámetros con un tiempo de actividad constante para cargas de trabajo de entrenamiento e inferencia de IA generativa a superescala.

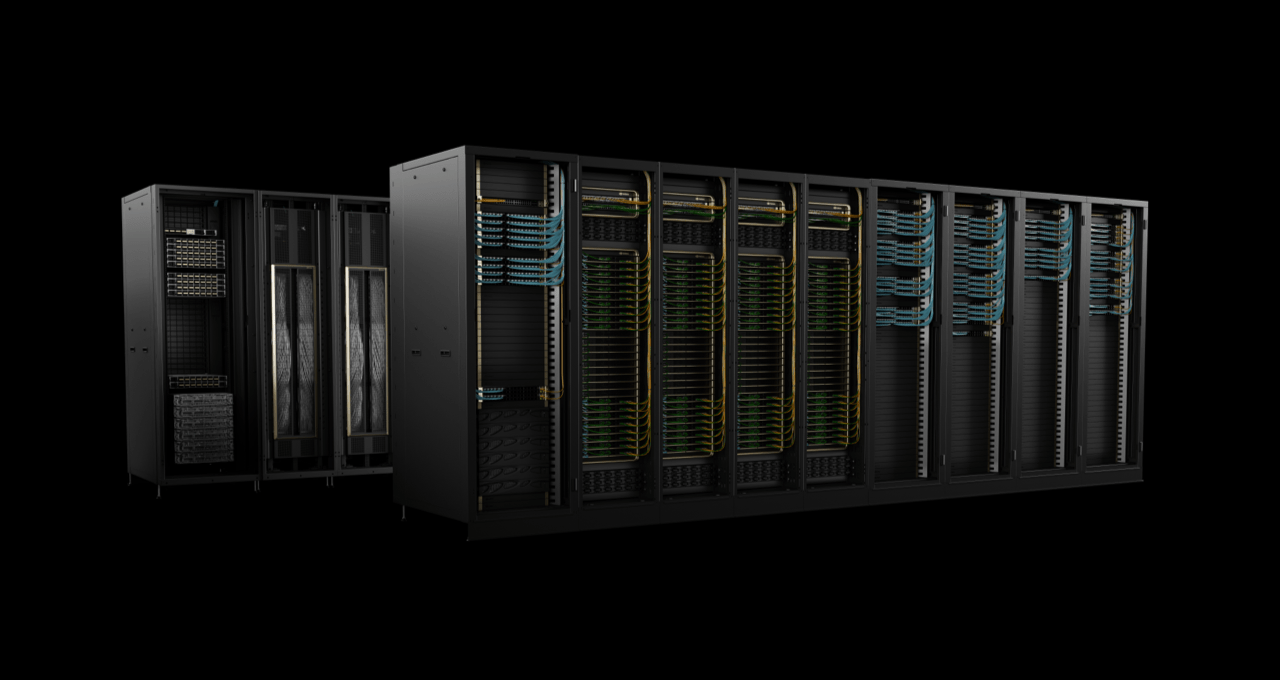

El nuevo DGX SuperPOD, dotado de una nueva arquitectura a escala de bastidor de alta eficiencia y refrigeración líquida, está construido con sistemas NVIDIA DGX™ GB200 y proporciona 11,5 exaflops de supercomputación de IA a precisión FP4 y 240 terabytes de memoria rápida, escalables a más con bastidores adicionales.

Grandes cargas de trabajo

Cada sistema DGX GB200 cuenta con 36 NVIDIA GB200 Superchips – que incluyen 36 CPU NVIDIA Grace y 72 GPU NVIDIA Blackwell – conectados como un superordenador a través de NVIDIA NVLink® de quinta generación. Los GB200 Superchips proporcionan hasta 30 veces más rendimiento que la GPU NVIDIA H100 Tensor Core para grandes cargas de trabajo de inferencia de modelos lingüísticos.

“Los superordenadores NVIDIA DGX AI son las fábricas de la revolución industrial de la IA”, afirma Jensen Huang, fundador y CEO de NVIDIA. “El nuevo DGX SuperPOD combina los últimos avances en computación acelerada, redes y software de NVIDIA para que todas las empresas, industrias y países puedan perfeccionar y generar su propia IA.”

El DGX SuperPOD impulsado por Grace Blackwell cuenta con ocho o más sistemas DGX GB200 y puede escalar hasta decenas de miles de GB200 Superchips conectados a través de NVIDIA Quantum InfiniBand. Para disponer de un espacio de memoria compartida masivo que alimente los modelos de IA de última generación, los clientes pueden implantar una configuración que conecte las 576 GPU Blackwell en ocho sistemas DGX GB200 conectados a través de NVLink.

Nueva arquitectura DGX SuperPOD a escala de rack para la era de la IA generativa

Los nuevos sistemas DGX SuperPOD con DGX GB200 incorporan una estructura de cálculo unificada. Además de NVIDIA NVLink de quinta generación, la estructura incluye las NVIDIA BlueField®-3 DPUs y será compatible con la red InfiniBand NVIDIA Quantum-X800, anunciada hoy por separado. Esta arquitectura proporciona hasta 1.800 gigabytes por segundo de ancho de banda a cada GPU de la plataforma.

Además, la tecnología NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ de cuarta generación proporciona 14,4 teraflops de cálculo en red, lo que supone multiplicar por 4 la capacidad de la arquitectura DGX SuperPOD de última generación en comparación con la generación anterior.

La arquitectura turnkey en mano se combina con un software avanzado para ofrecer un tiempo de actividad sin precedentes

El nuevo DGX SuperPOD es un completo superordenador de IA a escala de centro de datos que se integra con almacenamiento de alto rendimiento de partners certificados por NVIDIA para satisfacer las demandas de las cargas de trabajo de IA generativa. Cada uno se construye, cablea y prueba en la fábrica para acelerar drásticamente la implementación en los centros de datos de los clientes.

El DGX SuperPOD de Grace Blackwell cuenta con funciones inteligentes de gestión predictiva para supervisar continuamente miles de puntos de datos de hardware y software con el fin de predecir e interceptar las fuentes de inactividad e ineficiencia, ahorrando tiempo, energía y costes informáticos.

El software puede identificar áreas problemáticas y planificar el mantenimiento, ajustar con flexibilidad los recursos informáticos y guardar y reanudar automáticamente los trabajos para evitar tiempos de inactividad, incluso sin la presencia de administradores de sistemas.

Si el software detecta que es necesario sustituir un componente, el clúster activará la capacidad de reserva para garantizar que el trabajo termine a tiempo. Cualquier sustitución de hardware necesaria puede programarse para evitar tiempos de inactividad imprevistos.

Cualquier sustitución de hardware necesaria puede programarse para evitar tiempos de inactividad imprevistos.

“Este superordenador de última generación permitirá procesar cargas de trabajo de inferencia y entrenamiento generativo de IA, contribuyendo al rendimiento del mercado en su conjunto, en diversos sectores”, subraya Marcio Aguiar, director de la división Enterprise de NVIDIA para Latinoamérica.

Sistemas NVIDIA DGX B200 promueven la supercomputación de IA para industrias

NVIDIA también presentó el sistema NVIDIA DGX B200, una plataforma unificada de supercomputación de IA para entrenamiento, ajuste fino e inferencia de modelos de IA.

El DGX B200 es la sexta generación de diseños DGX tradicionales montados en bastidor y refrigerados por aire utilizados por industrias de todo el mundo. El nuevo sistema DGX B200 con arquitectura Blackwell incluye ocho GPU NVIDIA B200 Tensor Core y dos procesadores Intel® Xeon® de 5ª generación. Los clientes también pueden ensamblar el DGX SuperPOD utilizando sistemas DGX B200 para crear centros de excelencia de IA. Que pueden potenciar el trabajo de grandes equipos de desarrolladores que ejecutan muchos trabajos diferentes.

Los sistemas DGX B200 incluyen la función de precisión FP4 en la nueva arquitectura Blackwell. Lo que proporciona hasta 144 petaflops de rendimiento de IA, 1,4 TB de memoria de GPU y 64 TB/s de ancho de banda de memoria. Esto proporciona una inferencia en tiempo real 15 veces más rápida para modelos de billones de parámetros en comparación con la generación anterior.

Los sistemas DGX B200 incluyen redes avanzadas con ocho NICs NVIDIA ConnectX™-7 y dos DPUs BlueField-3. Proporcionan hasta 400 gigabits por segundo de ancho de banda por conexión, ofreciendo un rápido rendimiento de IA. Esto con las plataformas de red NVIDIA Quantum-2 InfiniBand y NVIDIA Spectrum™-X Ethernet.

Software y soporte especializados para escalar la producción de IA

Todas las plataformas NVIDIA DGX incluyen el software NVIDIA AI Enterprise para el desarrollo y la implantación a nivel empresarial. Los clientes de DGX pueden acelerar su trabajo con los modelos base, frameworks, kits de herramientas y nuevos microservicios NVIDIA NIM preentrenados. Incluidos en la plataforma de software.

Los expertos de NVIDIA DGX y una selección de partners de NVIDIA certificados para dar soporte a las plataformas DGX ayudan a los clientes en cada fase de la implantación. Esto para que puedan trasladar rápidamente la IA a la producción. Una vez que los sistemas estén operativos, los expertos de DGX seguirán ayudando a los clientes a optimizar sus pipelines e infraestructuras de IA.

Disponibilidad

Se espera que los sistemas NVIDIA DGX SuperPOD con DGX GB200 y DGX B200 estén disponibles a finales de este año. Esto a través de los partners globales de NVIDIA.

Para obtener más información, vea la repetición de la conferencia de GTC. O visite el stand de NVIDIA en la GTC, que se celebra en el Centro de Convenciones de San José hasta el 21 de marzo.

También te puede interesar: La plataforma NVIDIA Blackwell llega para impulsar una nueva era de computación

Y tú, geekzillo, ¿qué opinas de que NVIDIA lanza DGX SuperPOD con tecnología Blackwell para supercomputación de IA generativa? No olvides que puedes compartirnos tus opiniones en los comentarios.

Por último, puedes seguir la pista de esta y más noticias en T3 Latam, TechRadar México. Además de nuestros podcasts con Oye 89.7: Top Tech y Top Gaming en Spotify.