Esto de la inteligencia artificial se empieza a animar y cada vez vemos más y más modelos con diferentes objetivos y resultados. Ahora es el turno de Alibaba, el gigante del comercio chino, que acaba de presentar su nueva IA generativa bautizada como EMO.

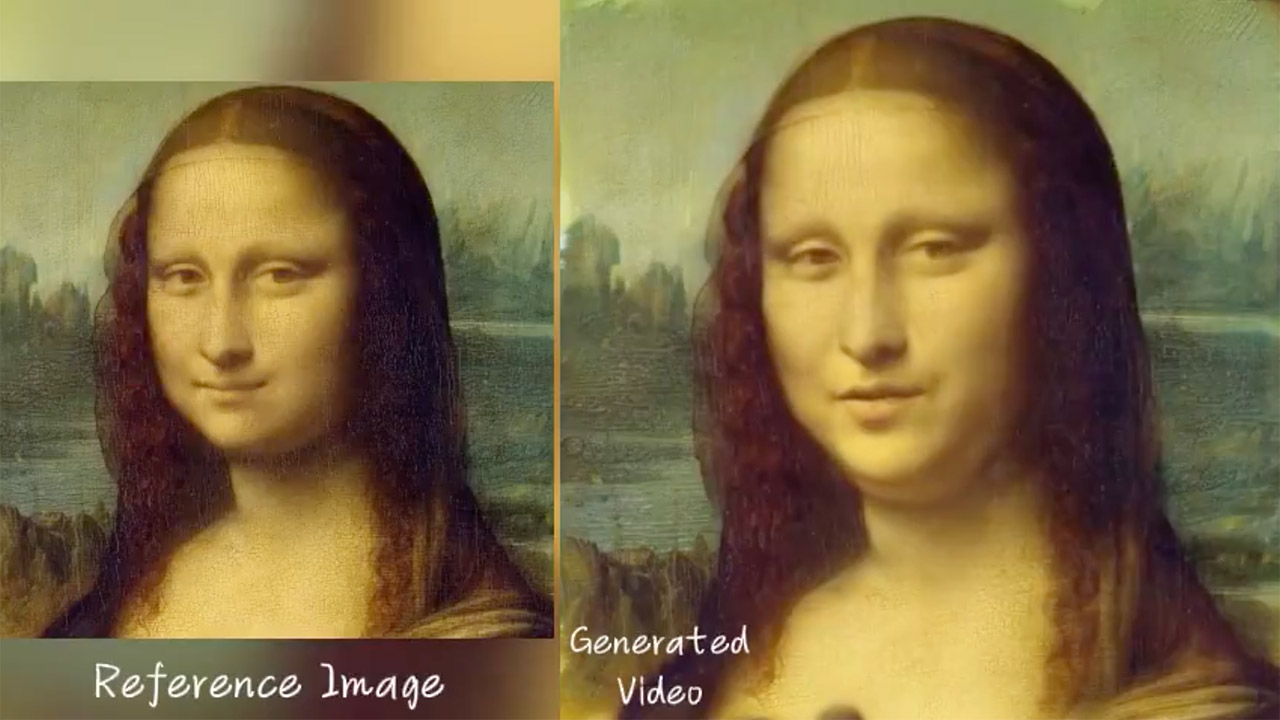

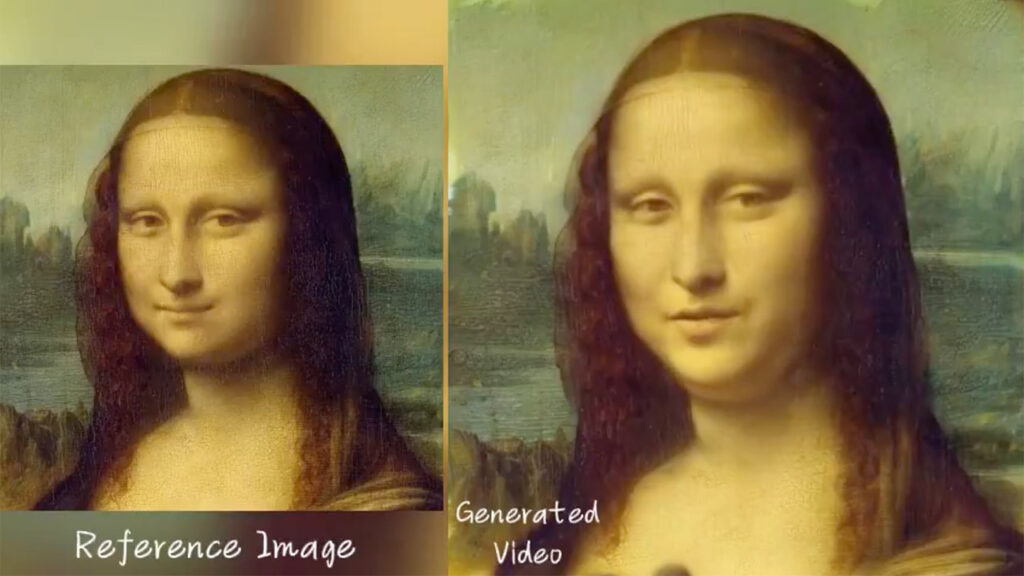

EMO o ‘Emote Portrait Alive’, es un modelo de inteligencia artificial generativa cuyo objetivo es generar videos a partir de imágenes. Pero lo más sorprendente es que en dichos videos las personas podrán “cobrar vida” ya sea cantando o simplemente hablando.

Sí, esto no es nuevo, ya hemos visto este tipo de soluciones con otras opciones que se encuentran actualmente en el mercado. Sin embargo, sí es la primera vez donde los resultados son sumamente realistas, resultados que impresionan a primera vista, que dejan a más de uno con la boca abierta.

Videos ultrarrealistas de retratos en movimiento con inteligencia artificial

Otro detalle interesante de EMO es que no proviene de las empresas habituales, sino de Alibaba, la compañía más importante de China, cuyo valor y alcance se equipara con Amazon. EMO ha sido desarrollada por el equipo de investigadores del instituto de inteligencia computacional de Alibaba en China, y, según explican, sólo necesitamos una fotografía más una pista de audio, la cual puede contener una canción o una simple voz hablando.

EMO tiene la capacidad de crear movimientos faciales fluidos, con expresiones de acuerdo al audio, así como una sincronía entre labios y sonido. Incluso los movimientos de la cabeza se mueven al ritmo de la música.

EMO : Emote Portrait Alive… Impresionante. pic.twitter.com/EKX3a2Cfhy

— Plácido Doménech Espí (@PlacidoDomenech) February 28, 2024

Los creadores de esta inteligencia artificial explican que para entrar a EMO se usaron más de 250 horas de videos. El contenido va desde conciertos, programas de televisión, películas y hasta discursos.

“Las técnicas tradicionales no suelen captar todo el espectro de expresiones humanas ni la singularidad de los estilos faciales individuales. Para resolver estos problemas, proponemos EMO, un novedoso modelo que utiliza un enfoque de síntesis directa de audio a vídeo, sin necesidad de modelos 3D intermedios ni puntos de referencia faciales”.

Linrui Tian, unos de los creadores de EMO

Te recomendamos: Sora: la nueva IA de OpenAI para transformar texto en video

Entrando en detalles un poco más técnicos, EMO emplea las ondas de audio para así convertirlas en video. Es capaz de captar movimientos del habla natural, desde el cierre de los ojos, muecas, movimientos únicos de labios, hasta rasgos específicos de la persona.

Cabe señalar que por el momento EMO no está abierto a todo el público, sólo a investigadores. Ahora mismo el objetivo es perfeccionarlo y tratar de encontrar fallos, así como tratar de evitar un mal uso. Respecto a esto último sabemos que las inteligencias artificiales son también un riesgo latente, y más en este nuevo modelo donde se puede crear a cualquier persona diciendo todo tipo de cosas.

Mientras tanto les dejo algunos ejemplos del increíble desempeño de EMO.

— AK (@_akhaliq) February 28, 2024

— AK (@_akhaliq) February 28, 2024