Tabla de contenidos

El GTC 22 de NVIDIA aún no termina, lo que significa que las sorpresas siguen y una de ellas es la GPU H100 Tensor Core, la cual estará en plena producción.

En octubre, los socios tecnológicos globales planean implementar la primera ola de productos y servicios basados en la innovadora arquitectura NVIDIA Pascal.

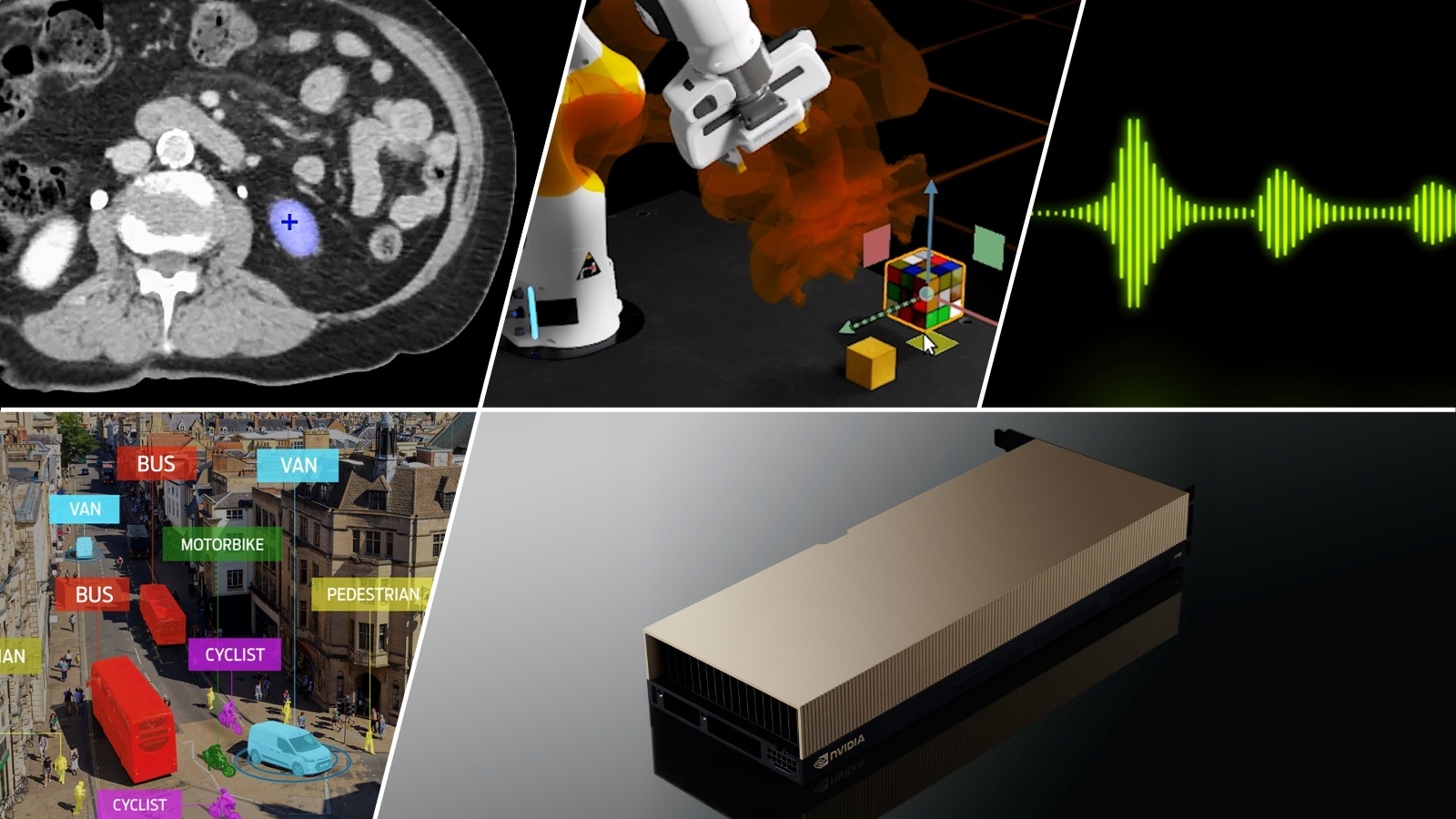

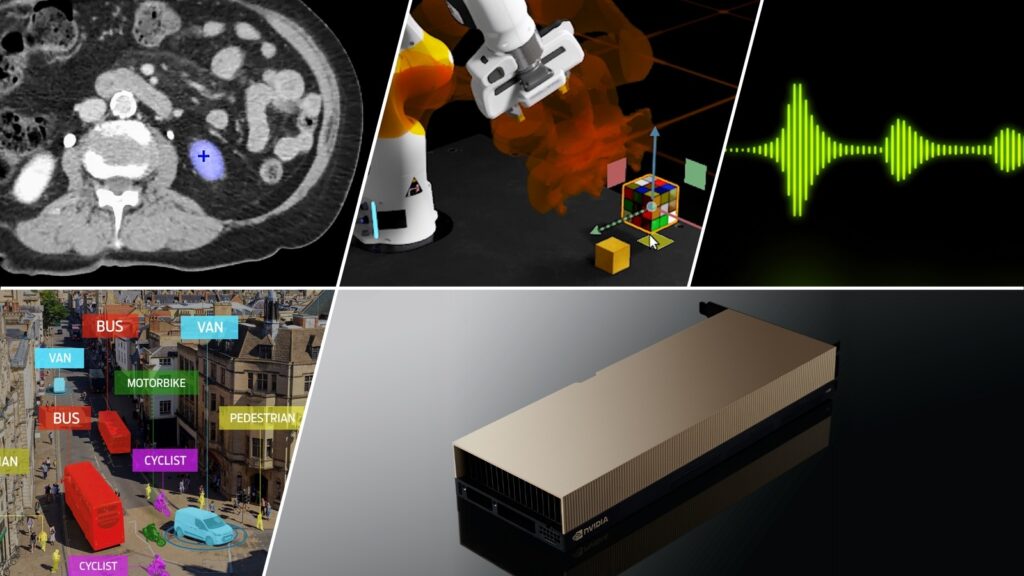

El modelo H100, que se presentó en abril, cuenta con 80,000 millones de transistores y se beneficia de diferentes avances tecnológicos. Entre ellos, se encuentran el nuevo y potente Motor Transformer y la interconexión NVIDIA NVLink para acelerar los modelos de IA más grandes. Como los sistemas de recomendación avanzados y los grandes modelos de idiomas. E impulsar innovaciones en campos como la IA conversacional y el descubrimiento de fármacos.

“Hopper es el nuevo motor de las fábricas de IA, que procesa y refina montañas de datos para entrenar modelos con billones de parámetros que se utilizan para impulsar los avances en IA basada en idiomas, robótica, atención de la salud y ciencias de la vida”, dijo Jensen Huang, fundador y CEO de NVIDIA. “El motor Transformer de Hopper aumenta el rendimiento hasta en un orden de magnitud, para poner la IA y la HPC a gran escala al alcance de empresas e investigadores”.

Además de la arquitectura Hopper y el Motor Transformer. Otras innovaciones clave potencian la GPU H100 para dar el próximo enorme salto en la plataforma de data center de computación acelerada de NVIDIA. Las cual incluye múltiples instancias de GPU de segunda generación, computación confidencial, instrucciones DE NVIDIA NVLink y DPX de cuarta generación.

Ahora se incluye una licencia de cinco años para la suite de software NVIDIA AI Enterprise con H100 para servidores convencionales. Esto optimiza el desarrollo y la implementación de workflows de IA y garantiza que las organizaciones tengan acceso a los frameworks y herramientas de IA necesarios para desarrollar chatbots de IA, motores de recomendación, IA de visión y más.

Lanzamiento Global de Hopper

H100 permite a las empresas reducir los costos para implementar la IA, a fin de ofrecer el mismo rendimiento de IA con una eficiencia energética 3.5 veces más grande y costo total de propiedad 3 veces menor, mientras usan 5 veces menos nodos de servidor en comparación con la generación anterior.

Para los clientes que quieren probar inmediatamente la nueva tecnología, NVIDIA anunció que H100 en los servidores Dell PowerEdge ya está disponible en NVIDIA LaunchPad, que proporciona laboratorios prácticos gratuitos para brindar a las empresas acceso al hardware más reciente y el software de IA de NVIDIA.

Los clientes también pueden comenzar a encargar los sistemas NVIDIA DGX H100. Las cuales incluyen ocho GPU H100 y ofrecen 32 petaflops de rendimiento con precisión FP8. El software NVIDIA Base Command y NVIDIA AI Enterprise potencian cada sistema DGX, lo que permite implementaciones desde un solo nodo hasta un NVIDIA DGX SuperPOD, que admiten el desarrollo avanzado de IA de grandes modelos de idiomas y otras enormes cargas de trabajo.

Se espera que los sistemas con NVIDIA H100 de los principales fabricantes de computadoras del mundo comenzarán a distribuirse en las próximas semanas. Habrá más de cincuenta modelos de servidores en el mercado para finales del año y docenas más en el primer semestre de 2023. Los socios que desarrollan sistemas incluyen Atos, Cisco, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Lenovo y Supermicro.

Además, algunas de las principales instituciones de educación superior e investigación del mundo usarán las H100 para potenciar sus supercomputadoras de próxima generación. Entre ellos se encuentran el Centro de Supercomputación de Barcelona, el Laboratorio Nacional de Los Alamos, el Centro Nacional de Supercomputación de Suiza (CSCS), el Centro de Computación Avanzada de Texas y la Universidad de Tsukuba.

H100 Llega al Cloud

Amazon Web Services, Google Cloud, Microsoft Azure y Oracle Cloud Infrastructure serán las primeras empresas en implementar instancias basadas en H100 en el cloud a partir del próximo año.

“Esperamos poder lograr la próxima generación de modelos de IA en las GPU H100 de NVIDIA más recientes de Microsoft Azure”, dijo Nidhi Chappell, gerente general de Infraestructura de IA de Azure. “Con los avances en la arquitectura Pascal, junto con nuestras inversiones en la supercomputación de IA de Azure, podremos ayudar a acelerar el desarrollo de la IA en todo el mundo”

“Al ofrecer a nuestros clientes las GPU H100 más recientes de NVIDIA, esperamos poder ayudarlos a acelerar sus cargas de trabajo de HPC y machine learning más exigentes”, dijo Karan Batta, vicepresidente de gestión de productos en Oracle Cloud Infrastructure. “Además, el uso de la próxima generación de GPU H100 de NVIDIA nos permite respaldar nuestras exigentes cargas de trabajo internas y ayudar a nuestros clientes mutuos a lograr avances en la atención de la salud, los vehículos autónomos, la robótica y la IoT”.

Soporte de Software de NVIDIA

La avanzada tecnología del Motor Transformer de H100 permite a las empresas desarrollar rápidamente grandes modelos de idiomas con un mayor nivel de precisión. A medida que estos modelos continúan creciendo en escala, también lo hace la complejidad, que a veces requiere meses para entrenarse.

Para hacer frente a esto, los frameworks de deep learning y los grandes modelos de idiomas se están optimizando en H100. Incluidos NVIDIA NeMo Megatron, Microsoft DeepSpeed, Google JAX, PyTorch, TensorFlow y XLA. Estos frameworks combinados con la arquitectura Hopper acelerarán significativamente el rendimiento de la IA para ayudar a entrenar grandes modelos de idiomas en días u horas.

Para obtener más información sobre NVIDIA Hopper y H100, mira el discurso destacado de GTC a cargo de Jensen Huang. Regístrate en GTC de forma gratuita para asistir a las sesiones con NVIDIA y los líderes de la industria hasta é Septiembre 22.

Recuerden que en Geekzilla.Tech podrán encontrar todas las novedades del GTC 22 de NVIDIA. Así que manténganse alerta de nuestro sitio web.